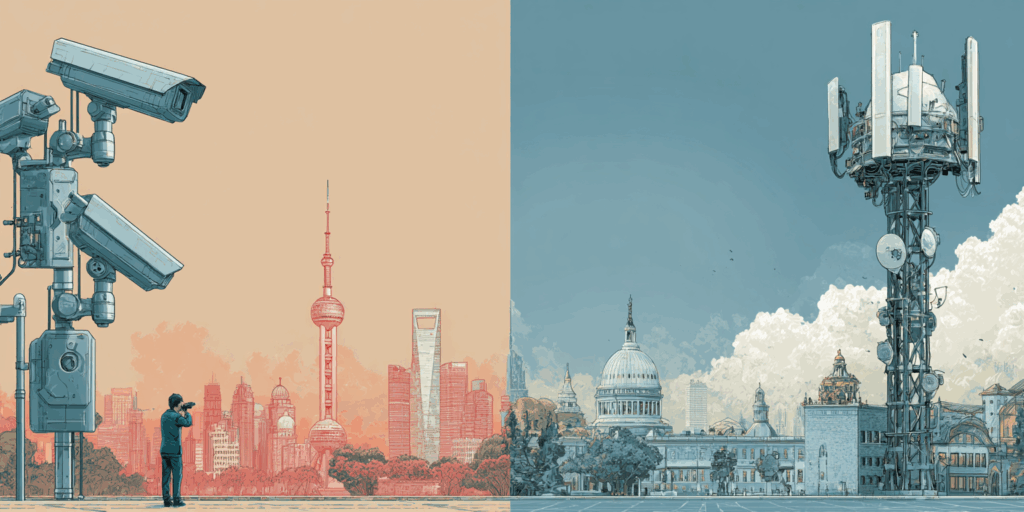

Face aux défis posés par l’intelligence artificielle, l’UE mise sur l’AI Act pour garantir la protection des droits fondamentaux ; la Chine adopte une stratégie de contrôle centralisé, orientée vers la stabilité sociale ; et les États-Unis privilégient une régulation fragmentée, axée sur la promotion de l’innovation. Trois continents, trois visions, qui façonnent les contours du futur numérique mondial.

L’intelligence artificielle ne suit pas une seule voie. Elle reflète les lois, les valeurs et les choix des grandes puissances qui la développent. L’Union européenne, la Chine et les États-Unis ont adopté des approches différentes pour encadrer cette technologie. Résultat : un paysage juridique mondial fragmenté. Pas de consensus, pas de règle commune. Trois modèles se dessinent, très différents, parfois opposés. Mais chacun avec une influence à l’échelle mondiale.

Trois continents, trois visions de l’intelligence artificielle

L’Union européenne a choisi de réguler l’intelligence artificielle par le droit. Avec l’AI Act (Règlement UE 2024/1689), elle devient la première à mettre en place un cadre juridique global, contraignant et transversal. Un texte extrêmement ambitieux qui s’applique à tous les secteurs — santé, justice, éducation, transports, etc. — et qui repose sur une idée clé : prévenir les risques avant qu’ils ne surviennent.

La Chine a choisi une voie différente. Sa régulation de l’IA cherche avant tout à protéger le régime et à préserver l’ordre social. Depuis 2021, plusieurs textes encadrent le développement de cette technologie. Au cœur du dispositif : les contenus générés par l’IA doivent respecter les « valeurs socialistes fondamentales ». Tout ce qui menace l’unité nationale ou propage des idées jugées subversives est strictement interdit.

Les États-Unis ont choisi une approche différente de celle de l’UE et de la Chine. Ainsi, en 2025, il n’existe toujours pas de loi fédérale sur l’IA. Aucun équivalent de l’AI Act adopté par le Congrès. À la place, Washington s’appuie sur un cadre souple, fondé sur des décrets présidentiels et des normes techniques volontaires.

Sous l’impulsion du président Biden, puis de son successeur, cette approche a mené à la création de l’AI Safety Institute. Ainsi qu’à des accords volontaires avec les grandes entreprises du secteur. Pour les Américains, il s’agit avant tout d’accélérer l’innovation pour garder une longueur d’avance sur la Chine. Au prix d’un allègement des règles, et donc d’une augmentation des risques liés à l’IA.

Trois modèles de régulation émergent ainsi. L’AI Act de l’UE privilégie la protection des droits fondamentaux ; la Chine impose le respect des valeurs socialistes et de l’ordre social ; et les USA favorisent l’innovation au détriment d’un encadrement strict.

En Europe, l’évaluation des risques liés à l’intelligence artificielle repose sur une classification en quatre niveaux, définie par l’AI Act.

Le premier niveau (« risque inacceptable ») regroupe les usages interdits, comme le fait de noter les citoyens ou d’utiliser les technologies de reconnaissance faciale dans les lieux publics. Le deuxième niveau (« risque élevé ») concerne les IA utilisées en santé, éducation, justice ou recrutement. Elles doivent suivre des règles strictes, avec un contrôle humain et des vérifications. Le troisième niveau (« risque limité ») comprend par exemple les chatbots, qui doivent suivre des règles de transparence strictes. Le dernier niveau, (« risque faible ») n’a pas de règles particulières.

En Chine, la classification des systèmes d’IA ne repose pas sur une échelle numérique. Les risques sont plutôt répartis en grandes catégories, telles que la sécurité nationale, l’éthique ou encore la désinformation.

Tout système d’intelligence artificielle destiné à un usage commercial doit par ailleurs passer une évaluation de sécurité et enregistrer ses algorithmes auprès de l’Administration du cyberespace de Chine (CAC).

Aux États-Unis, il n’existe pas de règles fédérales claires sur les IA à haut risque. Des projets de loi en parlent, mais rien n’est encore obligatoire. Chaque État décide de ses propres règles. En 2024, le Colorado a par exemple adopté une loi contre la discrimination par IA, ciblant des domaines comme le crédit ou l’embauche.

L’évaluation des risques révèle ainsi des approches contrastées. L’AI Act de l’UE impose une classification précise en quatre niveaux ; la Chine privilégie quant à elle un contrôle par catégories thématiques avec validation préalable ; et les USA maintiennent une régulation fragmentée au niveau des États fédérés.

Du contrôle centralisé chinois à l’approche fédérale américaine

En Europe, chaque pays choisit une ou plusieurs autorités pour faire respecter les règles sur l’IA. Un Office européen, créé en 2024, les aide à travailler ensemble. Un Conseil réunit aussi les régulateurs pour harmoniser les décisions. Ce système ressemble à celui du RGPD.

Les citoyens peuvent, en Europe, aussi agir : s’ils pensent qu’une IA porte atteinte à leurs droits, ils peuvent porter plainte. Ils ont aussi le droit de demander des explications sur toute décision prise automatiquement à leur sujet. Par exemple, en cas de refus de prêt basé sur une évaluation algorithmique, ils peuvent exiger de connaître les critères ayant conduit à cette décision.

Contrairement à l’approche collaborative de l’UE avec son AI Act et au système décentralisé des USA, la Chine privilégie une régulation centralisée sous l’autorité de la CAC. Cet organisme rédige les règles, supervise leur mise en œuvre et mène les audits de conformité.

Le cadre réglementaire chinois impose également des obligations strictes de transparence envers l’État. Les entreprises d’IA doivent transmettre régulièrement des rapports détaillés sur la sécurité, les algorithmes et les données utilisées. Ces informations ne sont toutefois ni rendues publiques ni accessibles aux citoyens.

Aux États-Unis, la régulation de l’IA est fragmentée. La Federal Trade Commission (FTC) agit contre les pratiques trompeuses ou discriminatoires. Tandis que le National Institute of Standards and Technology (NIST) publie des cadres volontaires comme l’AI Risk Management Framework. Plusieurs États ont par ailleurs lancé leurs propres initiatives, mais sans coordination nationale. Ce qui crée un paysage réglementaire difficile à suivre pour les entreprises.

Ainsi, l’AI Act privilégie la protection des droits fondamentaux en garantissant des recours effectifs ; la Chine mise quant à elle sur une surveillance étatique centralisée pour assurer la protection de ces droits ; Les États-Unis répartissent, eux, les responsabilités entre agences fédérales et initiatives locales, mais sans cadre unifié.

En Europe, la transparence est une exigence fondamentale en matière d’intelligence artificielle. Les systèmes à haut risque doivent faire l’objet d’une documentation rigoureuse, détaillant notamment les données utilisées, les choix de conception et les résultats des tests.

Des journaux d’activité (logs) doivent permettre de reconstituer chaque décision prise par le système. L’objectif est de garantir que l’IA reste compréhensible et contrôlable. Il ne s’agit pas seulement d’un enjeu technique, mais aussi d’un impératif juridique. Les décisions automatisées doivent pouvoir être vérifiées et, le cas échéant, contestées.

En Chine, la transparence prend une forme essentiellement administrative, plutôt que publique. Les entreprises sont tenues d’enregistrer leurs algorithmes auprès de la CAC. Ce qui permet aux autorités d’y accéder, sans pour autant rendre ces informations disponibles au grand public.

Aux États-Unis, la transparence en matière d’IA repose sur les lois générales de protection des consommateurs et sur la pression du marché. La FTC peut ainsi sanctionner les entreprises qui mentent sur les risques ou sur les capacités de leurs systèmes.

Des initiatives locales commencent toutefois à encadrer plus strictement son usage. En Californie, par exemple, la California AI Transparency Act (2026) oblige à signaler clairement quand un contenu est créé par une machine. Mais au niveau fédéral, il n’existe toujours pas d’obligation d’audit systématique des systèmes d’IA.

La transparence algorithmique révèle ainsi des priorités divergentes. L’AI Act de l’UE impose une traçabilité complète pour protéger les droits individuels ; la Chine privilégie un contrôle administratif opaque pour préserver l’ordre politique ; les USA s’appuient quant à eux sur des mécanismes de marché et des initiatives éparses au niveau des États.

- Partager l’article :

Notre blog est alimenté par les lecteurs. Lorsque vous achetez via des liens sur notre site, nous pouvons percevoir une commission d’affiliation.

Plus de détails sur l’article original.